7.4: Зміна поведінки через підкріплення та покарання - Оперантне кондиціонування

- Page ID

- 144296

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\dsum}{\displaystyle\sum\limits} \)

\( \newcommand{\dint}{\displaystyle\int\limits} \)

\( \newcommand{\dlim}{\displaystyle\lim\limits} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\(\newcommand{\longvect}{\overrightarrow}\)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\(\newcommand{\avec}{\mathbf a}\) \(\newcommand{\bvec}{\mathbf b}\) \(\newcommand{\cvec}{\mathbf c}\) \(\newcommand{\dvec}{\mathbf d}\) \(\newcommand{\dtil}{\widetilde{\mathbf d}}\) \(\newcommand{\evec}{\mathbf e}\) \(\newcommand{\fvec}{\mathbf f}\) \(\newcommand{\nvec}{\mathbf n}\) \(\newcommand{\pvec}{\mathbf p}\) \(\newcommand{\qvec}{\mathbf q}\) \(\newcommand{\svec}{\mathbf s}\) \(\newcommand{\tvec}{\mathbf t}\) \(\newcommand{\uvec}{\mathbf u}\) \(\newcommand{\vvec}{\mathbf v}\) \(\newcommand{\wvec}{\mathbf w}\) \(\newcommand{\xvec}{\mathbf x}\) \(\newcommand{\yvec}{\mathbf y}\) \(\newcommand{\zvec}{\mathbf z}\) \(\newcommand{\rvec}{\mathbf r}\) \(\newcommand{\mvec}{\mathbf m}\) \(\newcommand{\zerovec}{\mathbf 0}\) \(\newcommand{\onevec}{\mathbf 1}\) \(\newcommand{\real}{\mathbb R}\) \(\newcommand{\twovec}[2]{\left[\begin{array}{r}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\ctwovec}[2]{\left[\begin{array}{c}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\threevec}[3]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\cthreevec}[3]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\fourvec}[4]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\cfourvec}[4]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\fivevec}[5]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\cfivevec}[5]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\mattwo}[4]{\left[\begin{array}{rr}#1 \amp #2 \\ #3 \amp #4 \\ \end{array}\right]}\) \(\newcommand{\laspan}[1]{\text{Span}\{#1\}}\) \(\newcommand{\bcal}{\cal B}\) \(\newcommand{\ccal}{\cal C}\) \(\newcommand{\scal}{\cal S}\) \(\newcommand{\wcal}{\cal W}\) \(\newcommand{\ecal}{\cal E}\) \(\newcommand{\coords}[2]{\left\{#1\right\}_{#2}}\) \(\newcommand{\gray}[1]{\color{gray}{#1}}\) \(\newcommand{\lgray}[1]{\color{lightgray}{#1}}\) \(\newcommand{\rank}{\operatorname{rank}}\) \(\newcommand{\row}{\text{Row}}\) \(\newcommand{\col}{\text{Col}}\) \(\renewcommand{\row}{\text{Row}}\) \(\newcommand{\nul}{\text{Nul}}\) \(\newcommand{\var}{\text{Var}}\) \(\newcommand{\corr}{\text{corr}}\) \(\newcommand{\len}[1]{\left|#1\right|}\) \(\newcommand{\bbar}{\overline{\bvec}}\) \(\newcommand{\bhat}{\widehat{\bvec}}\) \(\newcommand{\bperp}{\bvec^\perp}\) \(\newcommand{\xhat}{\widehat{\xvec}}\) \(\newcommand{\vhat}{\widehat{\vvec}}\) \(\newcommand{\uhat}{\widehat{\uvec}}\) \(\newcommand{\what}{\widehat{\wvec}}\) \(\newcommand{\Sighat}{\widehat{\Sigma}}\) \(\newcommand{\lt}{<}\) \(\newcommand{\gt}{>}\) \(\newcommand{\amp}{&}\) \(\definecolor{fillinmathshade}{gray}{0.9}\)Цілі навчання

- Окресліть принципи оперантного кондиціонування.

- Поясніть, як навчання може бути сформовано через використання графіків підкріплення та вторинних підсилювачів.

У класичному кондиціонуванні організм вчиться пов'язувати нові подразники з природними, біологічними реакціями, такими як слиновиділення або страх. Організм не дізнається чогось нового, а швидше починає виконувати в існуючій поведінці при наявності нового сигналу. Оперантне кондиціонування, з іншого боку, - це навчання, яке відбувається на основі наслідків поведінки і може включати вивчення нових дій. Оперант кондиціонування відбувається, коли собака перекидається на команду, тому що вона була похвалена за це в минулому, коли шкільний хуліган загрожує своїм однокласникам, тому що це дозволяє йому пройти свій шлях, і коли дитина отримує хороші оцінки, тому що її батьки загрожують покарати її, якщо вона не. в оперант кондиціонування організм вчиться на наслідках власних дій.

Як підкріплення і покарання впливають на поведінку: дослідження Торндайка і Скіннера

Психолог Едвард Л.Торндайк (1874—1949) був першим вченим, який систематично вивчав оперантне кондиціонування. У своїх дослідженнях Торндайк (1898) спостерігав кішок, які були поміщені в «пазл», з якого вони намагалися втекти (відео). Спочатку кішки дряпали, кусаються, і махали непомітно, без жодного уявлення про те, як вибратися назовні. Але врешті-решт, і випадково, вони натиснули важіль, який відкрив двері і вийшов на свій приз, клаптик риби. Наступного разу, коли кіт був обмежений в коробці, він намагався менше неефективних відповідей перед здійсненням успішного втечі, і після декількох випробувань кішка навчилася майже відразу робити правильну відповідь.

Спостереження за цими змінами в поведінці кішок призвело Торндайка до розробки свого закону ефекту, принцип того, що відповіді, які створюють типово приємний результат у певній ситуації, швидше за все, знову відбуваються в подібній ситуації, тоді як відповіді, які виробляють типово неприємний результат рідше трапляються знову в ситуації (Торндайк, 1911). Суть закону ефекту полягає в тому, що успішні відповіді, оскільки вони приємні, «штамповані» досвідом і таким чином зустрічаються частіше. Невдалі відгуки, які виробляють неприємні переживання, «штамповані» і згодом виникають рідше.

Відео кліп: Коробка головоломки Торндайка. Коли Торндайк помістив своїх кішок в ящик для головоломки, він виявив, що вони навчилися займатися важливою поведінкою втечі швидше після кожного випробування. Торндайк описав навчання, яке слідує за підкріпленням з точки зору закону ефекту. https://youtu.be/BDujDOLre-8

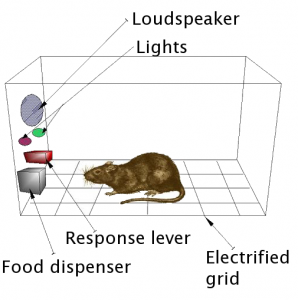

Впливовий поведінковий психолог Б.Ф. Скіннер (1904—1990) розширив ідеї Торндайка, щоб розробити більш повний набір принципів для пояснення оперантного кондиціонування. Скіннер створив спеціально розроблені середовища, відомі як оперантні камери (зазвичай називають Скіннер коробки ) для системного вивчення навчання. Коробка Скіннера (оперант камера) являє собою структуру, яка досить велика, щоб відповідати гризуна або птиці, і яка містить бар або ключ, який організм може натиснути або клювати, щоб звільнити їжу або воду. Він також містить пристрій для запису відгуків тварини.

Найосновніші експерименти Скіннера були досить схожі на дослідження Торндайка з кішками. Щур, поміщений в камеру, реагував, як можна було очікувати, снують про коробку і нюхаючи і кігнувши на підлогу і стіни. Врешті-решт щур скандувала важіль, яким вона натиснула, щоб випустити гранули їжі. Наступного разу навколо щури знадобилося трохи менше часу, щоб натиснути на важіль, і на послідовних випробуваннях час, необхідний для натискання важеля, ставало коротше і коротше. Незабаром щур так швидко натискала важіль, наскільки могла з'їсти з'явилася їжу. Як і передбачено законом ефекту, щур навчилася повторювати дію, яке принесло їжу і припиняти дії, які не робили.

Малюнок \(\PageIndex{6}\) Щур в коробці Скіннера. Б.Скіннер використовував коробку Скіннера для вивчення оперантного навчання. Коробка містить бар або ключ, який організм може натиснути для прийому їжі і води, і пристрій, який записує реакції організму. Andreas1 — Скіннер коробка — CC BY-SA 3.0.

Малюнок \(\PageIndex{6}\) Щур в коробці Скіннера. Б.Скіннер використовував коробку Скіннера для вивчення оперантного навчання. Коробка містить бар або ключ, який організм може натиснути для прийому їжі і води, і пристрій, який записує реакції організму. Andreas1 — Скіннер коробка — CC BY-SA 3.0.Скіннер детально вивчив, як тварини змінювали свою поведінку через підкріплення і покарання, і він розробив терміни, які пояснили процеси оперативного навчання (табл. \(\PageIndex{1}\)). Скіннер використовував термін підсилювач для позначення будь-якої події, яка зміцнює або збільшує ймовірність поведінки і термін каратель, щоб посилатися на будь-яку подію, яка послаблює або зменшує ймовірність поведінки . І він використовував терміни позитивні і негативні , щоб посилатися на те, було представлено або знято підкріплення відповідно. Таким чином позитивне підкріпленняпідсилюєвідповідь, представляючи щось приємне після відповідіі негативне підкріпленняпідсилює відповідь, зменшуючи або видаляючи щось неприємне. Наприклад, давати дитині похвалу за виконання своїх домашніх завдань є позитивним підкріпленням, тоді як прийом аспірину для зменшення болю головного болю є негативним підкріпленням. В обох випадках підкріплення робить більш імовірним, що поведінка знову відбудеться в майбутньому.

| Термін кондиціювання операційної системи | Опис | Результат | Приклад |

|---|---|---|---|

| позитивне підкріплення | Додати або збільшити приємний подразник | поведінка посилено | Надання студенту призу після того, як він отримає А на тест |

| негативне підкріплення | Зменшити або прибрати неприємний подразник | поведінка посилено | Прийом знеболюючих препаратів, що усувають біль, збільшує ймовірність того, що ви знову приймете знеболюючі препарати |

| позитивне покарання | Подаруйте або додайте неприємний подразник | поведінка ослаблена | Надання студенту додаткове домашнє завдання після того, як вона неправильно поводиться в класі |

| Негативне покарання | Зменшити або прибрати приємний подразник | поведінка ослаблена | Забираємо комп'ютер підлітка після того, як він пропускає комендантську годину |

Підкріплення, позитивне або негативне, працює за рахунок збільшення ймовірності поведінки. Покарання, з іншого боку, відноситься до будь-якої події, яка послаблює або знижує ймовірність того чи іншого поведінки. Позитивне покарання послаблює відповідь, пред'явивши щось неприємне після відповіді, тоді як негативне покарання послаблює відповідь за рахунок зменшення або видалення чогось приємного. Дитина, яка грунтується після боротьби з рідним братом (позитивне покарання) або втрачає можливість піти в поглиблення після отримання бідної оцінки (негативного покарання), рідше повторює ці поведінки.

Хоча відмінність між підкріпленням (що збільшує поведінку) і покаранням (що його зменшує) зазвичай зрозуміло, в деяких випадках важко визначити, позитивний чи негативний підкріплювач. У спекотний день прохолодний вітерець можна було розглядати як позитивний підсилювач (тому що він приносить прохолодне повітря) або негативний підсилювач (тому що він видаляє гаряче повітря). В інших випадках підкріплення може бути як позитивним, так і негативним. Можна курити сигарету як тому, що вона приносить задоволення (позитивне підкріплення), так і тому, що вона усуває тягу до нікотину (негативне підкріплення).

Також важливо відзначити, що підкріплення і покарання - це не просто протилежності. Використання позитивного підкріплення в зміні поведінки практично завжди ефективніше, ніж використання покарання. Це тому, що позитивне підкріплення змушує людину або тварину відчувати себе краще, допомагаючи створити позитивні відносини з людиною, що забезпечує підкріплення. Види позитивного підкріплення, які ефективні в повсякденному житті, включають словесну похвалу або схвалення, присудження статусу або престижу, а також прямий фінансовий платіж. Покарання, з іншого боку, швидше за все створює лише тимчасові зміни в поведінці, оскільки воно засноване на примусі і, як правило, створює негативні і змагальні відносини з особою, що забезпечує підкріплення. Коли людина, яка забезпечує покарання, залишає ситуацію, то небажана поведінка, швидше за все, повернеться.

Створення складної поведінки за допомогою оперантного кондиціонування

Можливо, ви пам'ятаєте перегляд фільму або перебування на шоу, в якому тварина - можливо, собака, кінь або дельфін - робили деякі досить дивовижні речі. Дресирувальник дав команду і дельфін плавав на дно басейну, підняв кільце на носі, вискочив з води через обруч в повітрі, знову пірнув на дно басейну, взяв в руки ще одне кільце, а потім взяв обидва кільця до дресирувальника біля краю басейну. Тварина навчили робити трюк, і принципи оперантного кондиціонування використовувалися для його дресирування. Але ці складні поведінки є далеко криком від простих відносин стимулу-реагування, які ми розглянули до цих пір. Як можна використовувати підкріплення для створення складних поведінки, таких як ці?

Одним із способів розширити використання оперантного навчання є зміна графіка, за яким застосовується підкріплення. До цього моменту ми обговорювали лише безперервний графік підкріплення, в якому бажана відповідь посилюється кожного разу, колисобака перевертається, наприклад, вона отримує печиво. Безперервне підкріплення призводить до відносно швидкого навчання, але також швидкого вимирання бажаної поведінки, коли підсилювач зникає. Проблема полягає в тому, що через те, що організм звик отримувати підкріплення після кожної поведінки, відповідач може швидко відмовитися, коли воно не з'явиться.

Більшість підсилювачів реального світу не є безперервними; вони відбуваються на частковому (або переривчастому) графіку підсилення- графік, в якому відповіді іноді посилюються, а іноді і ні. У порівнянні з безперервним підкріпленням, графіки часткового підкріплення призводять до повільного початкового навчання, але вони також призводять до більшої стійкості до вимирання. Оскільки підкріплення не з'являється після кожної поведінки, учню потрібно більше часу, щоб визначити, що нагорода більше не настає, і, таким чином, вимирання повільніше. Чотири типи графіків часткового армування зведені в табл \(\PageIndex{2}\).

| Графік армування | пояснення | Приклад реального світу |

|---|---|---|

| Фіксований коефіцієнт | Поведінка підкріплюється після певної кількості відповідей | Заводчі, які оплачуються відповідно до кількості продукції, яку вони виробляють |

| Співвідношення зі змінною | Поведінка підкріплюється після середнього, але непередбачуваного, кількості відповідей | Виплати з ігрових автоматів та інших азартних ігор |

| Фіксований інтервал | Поведінка підкріплюється для першої відповіді після того, як пройшло певний проміжок часу | Люди, які заробляють щомісячну зарплату |

| Змінний інтервал | Поведінка підкріплюється для першої відповіді після того, як пройшло середнє, але непередбачуване, кількість часу | Людина, яка перевіряє голосову пошту на наявність |

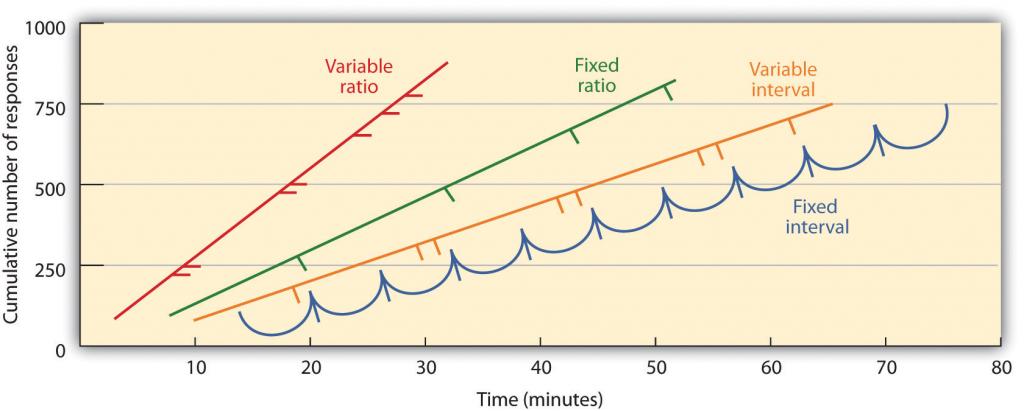

Часткові графіки армування визначаються тим, чи представляється арматура на основі часу, що проходить між арматурою (інтервалом) або на підставі кількості відповідей, якими займається організм (співвідношенням), і тим, чи відбувається підкріплення на регулярному (фіксованому) або непередбачуваний (змінний) графік. У графіці фіксованого інтервалу відбувається підкріплення для першого відгуку, зробленого після того, як пройшло певний проміжок часу. Наприклад, за однохвилинним графіком фіксованого інтервалу тварина отримує підкріплення щохвилини, припускаючи, що вона бере участь у поведінці принаймні один раз протягом хвилини. Як ви можете бачити на рисунку \(\PageIndex{7}\), тварини за графіками фіксованого інтервалу, як правило, сповільнюють свою реакцію відразу після підкріплення, але потім знову збільшують поведінку, коли час наступного підкріплення стає ближче. (Більшість студентів навчаються на іспитах так само.) У змінно-інтервальному графіку підсилювачі з'являються за інтервальним графіком, але терміни змінюються навколо середнього інтервалу, роблячи фактичний зовнішній вигляд арматора непередбачуваним. Прикладом може бути перевірка вашої електронної пошти: Ви підкріплені отриманням повідомлень, які приходять, в середньому, говорять кожні 30 хвилин, але підкріплення відбувається лише у випадковий час. Інтервал підсилення графіків, як правило, виробляють повільні і стійкі темпи реагування.

Малюнок \(\PageIndex{7}\) Приклади моделей реагування тварин, підготовлених за різними графіками часткового підкріплення. Розклади, засновані на кількості відповідей (типи співвідношень), викликають більшу швидкість відгуку, ніж графіки на основі минулого часу (типи інтервалів). Крім того, непередбачувані графіки (типи змінних) дають сильніші відповіді, ніж передбачувані графіки (фіксовані типи). Адаптовано з Касіна, С. (2003). Основи психології. Верхнє Сідло річки, Нью-Джерсі: Прентіс-зал. Отримано з Основи психології Prentice Холл Компаньйон веб-сайт: wps.prenhall.com/hss_kassin_essin_essentials_1/15/3933/1006917.cw/index.html.

Малюнок \(\PageIndex{7}\) Приклади моделей реагування тварин, підготовлених за різними графіками часткового підкріплення. Розклади, засновані на кількості відповідей (типи співвідношень), викликають більшу швидкість відгуку, ніж графіки на основі минулого часу (типи інтервалів). Крім того, непередбачувані графіки (типи змінних) дають сильніші відповіді, ніж передбачувані графіки (фіксовані типи). Адаптовано з Касіна, С. (2003). Основи психології. Верхнє Сідло річки, Нью-Джерсі: Прентіс-зал. Отримано з Основи психології Prentice Холл Компаньйон веб-сайт: wps.prenhall.com/hss_kassin_essin_essentials_1/15/3933/1006917.cw/index.html.У графіку фіксованого співвідношення поведінка посилюється після певної кількості відповідей. Наприклад, поведінка щура може бути посилена після того, як вона натиснула клавішу 20 разів, або продавець може отримати бонус після того, як вона продала 10 продуктів. Як видно на малюнку \(\PageIndex{7}\), як тільки організм навчився діяти відповідно до графіком фіксованого підкріплення, він зупиниться лише ненадовго, коли відбудеться підкріплення до повернення на високий рівень чуйності. Графік зі змінним співвідношенням забезпечує арматори після певного, але середнього числа відповідей. Виграш грошей з ігрових автоматів або на лотерейний квиток є прикладами підкріплення, які відбуваються за розкладом зі змінним співвідношенням. Наприклад, ігровий автомат може бути запрограмований, щоб забезпечити виграш кожні 20 разів, коли користувач тягне ручку, в середньому. Як ви можете бачити на рисунку \(\PageIndex{8}\), графіки співвідношення, як правило, виробляють високі темпи реагування, оскільки посилення збільшується в міру збільшення кількості відповідей.

Малюнок \(\PageIndex{8}\): Ігровий автомат. Ігрові автомати є прикладами графіка підсилення зі змінним співвідношенням. Джефф Кубіна - Ігровий автомат - CC BY-SA 2.0.

Малюнок \(\PageIndex{8}\): Ігровий автомат. Ігрові автомати є прикладами графіка підсилення зі змінним співвідношенням. Джефф Кубіна - Ігровий автомат - CC BY-SA 2.0.Складна поведінка також створюється через шейпінг, процес наведення поведінки організму до бажаного результату шляхом використання послідовного наближення до остаточного бажаної поведінки. Скіннер широко використовував цю процедуру в своїх коробках. Наприклад, він міг навчити щура двічі натискати на штангу, щоб отримувати їжу, попередньо забезпечивши їжу, коли тварина рухалася біля бару. Тоді, коли ця поведінка була вивчена, він почне забезпечувати їжу тільки тоді, коли щур торкнувся планки. Подальше формування обмежувалося арматурою тільки тоді, коли щур притискала планку, щоб коли вона притискала планку і торкнулася її вдруге, і, нарешті, тільки тоді, коли вона натиснула брусок двічі. Хоча це може зайняти багато часу, таким чином оперантне кондиціонування може створювати ланцюги поведінки, які посилюються тільки тоді, коли вони будуть завершені.

Посилення тварин, якщо вони правильно дискримінують між подібними стимулами, дозволяє вченим перевірити здатність тварин до навчання, а дискримінації, які вони можуть зробити, іноді досить чудові. Голуби пройшли навчання розрізняти образи Чарлі Брауна та інших персонажів Арахісу (Cerella, 1980) та між різними стилями музики та мистецтва (Porter & Neuringer, 1984; Watanabe, Sakamoto & Wakita, 1995).

Поведінка також може бути навчена за допомогою використання вторинних підсилювачів. У той час як первинний підсилювач включає стимули, які природно віддають перевагу або користуються організмом, такі як їжа, вода та полегшення від болю, вторинний підсилювач (іноді називають умовним підсилювачем) є нейтральною подією, яка стала пов'язана з первинним армування за допомогою класичного кондиціонування. Прикладом вторинного підсилювача може бути свисток, наданий дресирувальником тварин, який був пов'язаний з часом з первинним підсилювачем, їжею. Приклад повсякденного вторинного підсилювача - гроші. Нам подобається мати гроші, не стільки для самого стимулу, скільки для первинних підсилювачів (речей, які можна купити гроші), з якими це пов'язано.

Ключові винос

- Едвард Торндайк розробив закон ефекту: принцип того, що відповіді, які створюють типово приємний результат у певній ситуації, швидше за все, знову відбуваються в подібній ситуації, тоді як відповіді, які виробляють типово неприємний результат, рідше трапляються знову в ситуації.

- Б.Скіннер розширився на ідеї Торндайка, щоб розробити набір принципів для пояснення оперантного кондиціонування.

- Позитивне підкріплення підсилює відповідь, представляючи щось, що зазвичай приємно після відповіді, тоді як негативне підкріплення підсилює відповідь, зменшуючи або видаляючи щось, що, як правило, неприємно.

- Позитивне покарання послаблює відповідь, представляючи щось типово неприємне після відповіді, тоді як негативне покарання послаблює відповідь, зменшуючи або видаляючи щось, що зазвичай приємно.

- Армування може бути як частковим, так і суцільним. Часткові графіки армування визначаються тим, чи представляється арматура на основі часу, що проходить між підкріпленнями (інтервалом) або на підставі кількості відповідей, які організм бере участь (співвідношення), і за тим, чи відбувається підкріплення на регулярному (фіксованому) або непередбачуваний (змінний) графік.

- Складна поведінка може створюватися через формування, процес наведення поведінки організму до бажаного результату шляхом використання послідовного наближення до остаточної бажаної поведінки.

Вправи і критичне мислення

- Наведіть приклад з повсякденного життя кожного з наступних: позитивне підкріплення, негативне підкріплення, позитивне покарання, негативне покарання.

- Розглянемо методи підкріплення, які ви можете використовувати, щоб навчити собаку, щоб зловити і отримати фрісбі, що ви кидаєте до нього.

- Подивіться наступні два відео з поточних телевізійних шоу. Чи можете ви визначити, які навчальні процедури демонструються?

- Офіс: www.break.com/usercontent/2009/11/office-altoid- експеримент-1499823

- Теорія великого вибуху: http://www.youtube.com/watch?v=JA96Fba-WHk

Посилання

Церелла, Дж. (1980). Аналіз картин голуба. Розпізнавання образів, 12, 1-6.

Портер Д., Нейрингер А. Музичні дискримінації голубів. Журнал експериментальної психології: процеси поведінки тварин, 10(2), 138—148;

Торндайк, Е.Л. (1898). Інтелект тварин: Експериментальне дослідження асоціативних процесів у тварин. Вашингтон, округ Колумбія: Американська психологічна асоціація.

Торндайк, Е.Л. (1911). Розум тварин: Експериментальні дослідження. Нью-Йорк, Нью-Йорк: Макміллан. Отримано з сайту http://www.archive.org/details/animalintelligen00thor

Ватанабе С., Сакамото, Дж., & Вакіта М. (1995). Дискримінація голубів картини Моне і Пікассо. Журнал експериментального аналізу поведінки, 63(2), 165—174.